L’intelligence artificielle (IA) a révolutionné notre monde, en rendant de nombreux processus plus efficaces et les tâches plus accessibles. Cependant, parallèlement à ses avantages, l’IA présente des risques importants, en particulier lorsqu’il s’agit de technologies telles que les deepfakes.

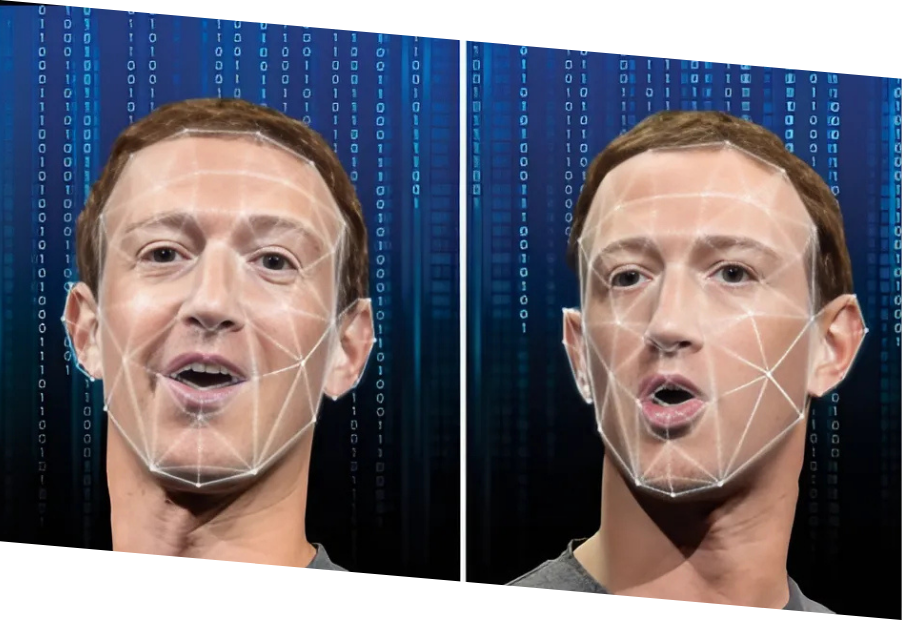

Les deepfakes désignent des altérations très convaincantes et réalistes de médias existants, réalisées par des algorithmes basés sur l’IA qui manipulent des images, des vidéos ou des fichiers audio pour imiter de vraies personnes. Par exemple, de multiples applications et logiciels peuvent échanger des visages dans des vidéos ou des images, animer ou modifier des images, imiter des voix avec une précision troublante, ou même générer des scénarios entièrement faux qui pourraient sembler réels à un œil non averti, du moins à première vue. Ces créations sont alimentées par des modèles d’apprentissage automatique qui analysent de grandes quantités de données pour reproduire des modèles, des voix et des repères visuels.

Si cette technologie présente un potentiel incroyable pour des usages créatifs et éducatifs, ses dangers ne doivent être négligés. D’abord considérée comme une nouveauté dans le domaine du divertissement pour créer des contenus amusants ou exclusifs, la technologie deepfake a évolué vers des applications nuisibles menaçant la vie privée, la réputation, les questions juridiques et la confiance de la société.

Désinformation et fausses informations

L’un des dangers les plus alarmants des deepfakes réside dans leur capacité à diffuser de fausses informations en imitant des personnes dans diverses situations. De fausses vidéos de personnalités publiques ou de personnes ordinaires faisant des déclarations incendiaires, adoptant un comportement inapproprié ou se retrouvant dans des situations compromettantes peuvent devenir virales, semant la discorde et la confusion. Le réalisme sans faille des deepfakes, lorsqu’ils sont bien faits, rend difficile pour le public de distinguer la réalité de la fiction, ce qui peut affecter la confiance dans les sources d’information légitimes, endommager des réputations et des opportunités d’emploi, ou même conduire à des campagnes de diffamation, des conflits politiques et des accusations criminelles.

Cyberintimidation et harcèlement

Les deepfakes ont été utilisés comme arme pour des attaques personnelles, visant en particulier des personnes vulnérables avec de fausses vidéos ou images pouvant être utilisées pour de la cyberintimidation, du chantage ou des atteintes à la réputation. Les victimes ont souvent du mal à prouver que le contenu est fabriqué, en raison de son réalisme, ce qui les laisse sans recours et affecte profondément leur vie.

Escroqueries et fraudes financières

L’imitation vocale basée sur l’IA a permis à des criminels de se faire passer pour des autorités, des PDG, des employés, des artistes ou des proches dans des appels téléphoniques ou des messages audio, convaincant ainsi les victimes de transférer de l’argent ou de divulguer des informations sensibles. En outre, ils peuvent être utilisés pour contourner les fonctions de reconnaissance faciale afin d’accéder à certains appareils. Ces stratagèmes exploitent la confiance et peuvent causer d’importants dommages financiers.

Atteinte à la confiance dans les médias

À mesure que les deepfakes deviennent plus difficiles à détecter, le public peut commencer à remettre en question l’authenticité de tous les médias, à douter des sources crédibles, ce qui peut nuire au journalisme, aux preuves scientifiques et même aux communications personnelles, créant un environnement de scepticisme constant et de théories du complot.

L’éducation aux compétences numériques est la première ligne de défense contre les menaces des deepfakes. Il faut être conscient de l’existence de ces technologies et de leurs capacités, afin de les reconnaître et de pouvoir contrer leurs effets. Voici quelques mesures à prendre pour se prémunir contre leurs dangers :

- Vérifier les sources : toujours vérifier l’origine du contenu médiatique, surtout s’il suscite une forte réaction émotionnelle. Les médias et les services de vérification des informations réputés peuvent aider à vérifier l’authenticité.

- Analyser la cohérence : s’assurer que le contenu, sa source et ses métadonnées, ainsi que les types de comportements ou de demandes, correspondent à d’autres sources ou à des contenus antérieurs provenant de la ou des mêmes personnes représentées ou les concernant.

- Utiliser des outils de détection IA : Des outils et des logiciels émergent pour détecter les deepfakes, bien que la technologie reste en constante course avec les créateurs de deepfakes.

- Promouvoir la culture numérique : Enseigner la culture numérique, comme comprendre comment les médias sont créés et manipulés et analyser les signes révélateurs de manipulation audio et visuelle, aide les individus à évaluer de manière critique ce qu’ils voient et entendent en ligne.

Le projet DigiCity permet aux apprenants âgés de 16 à 25 ans d’acquérir les compétences nécessaires pour relever les défis numériques tels que les deepfakes, par exemple, en présentant leur application réelle et leurs conséquences dans une histoire engageante et interactive à travers un jeu vidéo et un jeu d’évasion. Grâce à l’apprentissage par le jeu, les participants développent leur esprit critique pour identifier les médias synthétiques et y répondre.

En favorisant la prise de conscience et en enseignant des stratégies pratiques, DigiCity donne les moyens à une génération de citoyens numériques responsables de lutter contre les dangers d’une mauvaise utilisation de l’IA. Ensemble, nous pouvons faire en sorte que les avantages de la technologie l’emportent sur ses risques, en construisant un monde numérique plus sûr grâce à la formation de citoyens numériques informés et compétents !

Source de l’image: towardsdatascience.com

Pour aller plus loin :

- Standford University IT. (2024). Dangers of Deepfake: What to watch for. https://uit.stanford.edu/news/dangers-deepfake-what-watch

- DHS Homeland Security. (n.d.). Increasing threat of DeepFake identities. https://www.dhs.gov/sites/default/files/publications/increasing_threats_of_deepfake_identities_0.pdf

- O. Lawal on CyberPhorm. (n.d.). What Is Deepfake and How Dangerous Is it For You and National Security? https://cyberphorm.com/what-is-deepfake-and-why-is-it-dangerous/

- Naik on CoolTechZone. (2022). Deepfake crimes: How Real And Dangerous They Are In 2021? https://cooltechzone.com/research/deepfake-crimes